“Trong khi các nhà khoa học máy tính tập trung vào việc cải thiện hiệu suất mô hình AI, các bác sĩ hoặc nhà kinh tế chỉ quan tâm tại sao và làm cách nào mô hình có thể đưa ra quyết định.”

1. Tại sao phải cần XAI?

Kể từ khi chatGPT được giới thiệu vào đầu năm 2023, thì cơn bão mang tên GPT vẫn chưa dừng lại và tiếp tục tạo ra tác động đáng kể cả trong giới nghiên cứu và các lĩnh vực ứng dụng AI. Nhưng trước sức mạnh của một trí tuệ nhân tạo như thế, nhiều người đã dấy lên một câu hỏi “Liệu rằng AI có đáng tin cậy?”. Cụm từ “Hallucinate”, được bình chọn là từ của năm 2023, mô tả việc các mô hình AI đưa ra những thông tin không chính xác một cách thuyết phục như thể chúng là sự thật. Từ đó chúng ta có thể thấy được “độ tin cậy” vào AI là một vấn đề nổi trội đang được quan tâm hơn gần đây ở cả khía cạnh nghiên cứu và ứng dụng. Phần lớn các nhà nghiên cứu khoa học máy tính thường tập trung vào việc phát triển các mô hình/thuật toán AI để đạt được hiệu suất cao. Tuy nhiên, ở một khía cạnh khác, khi AI được ứng dụng vào các lĩnh vực quan trọng như kinh tế-tài chính, y tế thì AI được yêu cầu phải giải thích được các quyết định của mình. Ví dụ, người bác sĩ sẽ quan tâm tại sao và dựa vào các triệu chứng, dấu hiệu nào mà AI chẩn đoán bệnh nhân của họ mắc bệnh. Hay các nhà kinh tế muốn biết tại sao AI lại lựa chọn mã chứng khoán này để đầu tư mà không phải mã khác. Các quyết định của AI trên các lĩnh vực này nếu sai lệch có thể để lại nhiều hậu quả nghiêm trọng, vì vậy để ứng dụng được AI cho lĩnh vực này thì AI phải chứng minh được độ tin cậy của mình.

Để đảm bảo được độ tin cậy của mình, các mô hình AI phải có khả năng giải thích được các quyết định và suy luận của mình một cách tường minh và dễ hiểu cho người sử dụng. Từ đó giúp người sử dụng quyết định có nên dùng các mô hình AI hay không. Từ đây khái niệm về Explainable AI (XAI) (Trí tuệ nhân tạo có thể giải thích) được ra đời. XAI nhằm giải thích, diễn giải các quyết định và dự đoán mà nó đưa ra từ đó giúp nó trở thành một mô hình minh bạch mà người dùng có thể hiểu được.

2. XAI là gì?

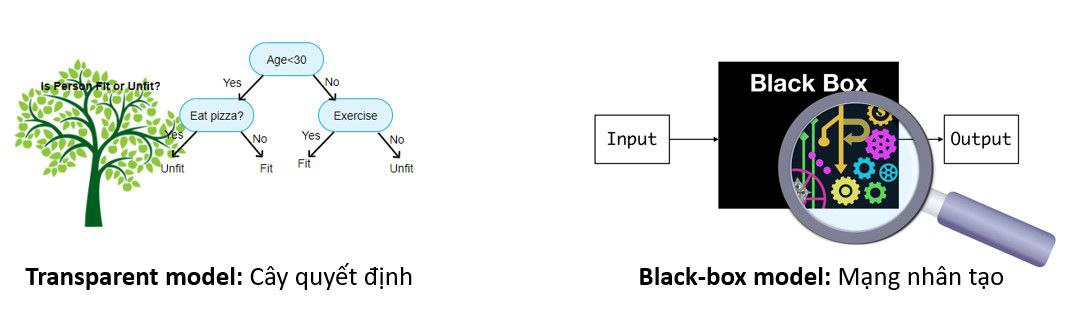

Giải thích là một khái niệm định tính được xuất phát từ lĩnh vực triết học. Vì vậy khi được sử dụng ở lĩnh vực khoa học máy tính rất khó để định lượng sự giải thích là thế nào. Đã có rất nhiều nhà khoa học đề xuất, phát biểu về khả năng giải thích của Trí tuệ nhân tạo. Nhưng tựu chung lại, XAI xoay quanh việc cung cấp cho người dùng một cách chi tiết và dễ hiểu về cách mà các mô hình đưa ra dự đoán hoặc suy luận. Dựa trên tính minh bạch (transparent) có thể chia mô hình làm 2 loại: mô hình minh bạch (transparent model) có khả năng tự giải thích các quyết định của mô hình và ngược lại là mô hình hộp đen (black-box model). Các mô hình minh mạch có thể tự cung cấp cho người dùng cách thức và lí do tại sao mô hình đưa ra quyết định. Ví dụ cho loại mô hình này là Decision Tree, các mô hình Decision Tree đưa ra quyết định dựa trên một tập các quy tắc vì thế người dừng có thể hiểu được tại sao mô hình dự đoán ra kết quả. Ngược lại, các mô hình hộp đen, ví dụ như mạng neural nhân tạo, không thể tự giải thích cho dự đoán của mô hình nên thường phải dùng thêm một mô hình khác để giải thích cho mô hình gốc.

Hình 1: Ví dụ về mô hình minh bạch cây quyết định (bên trái) và mô hình mạng nhân tạo (bên phải).

3. Hiện tại có những hướng tiếp cận nào cho XAI?

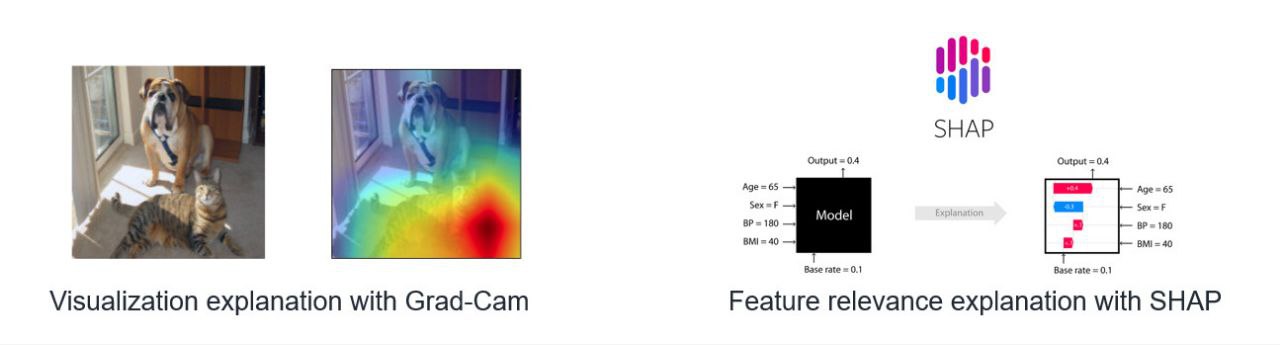

Dựa trên tính minh bạch (transparent) của mô hình như đã trình bày ở phần trước, hướng tiếp cận cho việc nghiên cứu và phát triển các mô hình XAI được chia làm 2 loại là transparent model (mô hình minh mạch) và kỹ thuật post-hoc explainability dùng để giải thích cho các mô hình hộp đen. Các mô hình thuộc loại transparent model, là các mô hình mà khả năng giải thích và diễn giải của nó được thiết kế trong chính mô hình, đôi khi nó được xem là một tính năng của mô hình. Một số ví dụ của các mô hình loại này là Linear Regression hay Decision Tree. Kết quả đầu ra của Linear Regression sẽ phụ thuộc vào hàm số y = w^1x^1 + w^2x^2 + … + w^nx^n + b sau khi được huấn luyện qua dữ liệu. Dựa vào hàm số học được, người dùng có thể hiểu tại sao mô hình lại đưa ra các kết quả dự đoán. Đối với Decision Tree, như được trình bày ở phần trên, người dùng có thể hiểu được kết quả dự đoán mô hình thông qua tập quy tắc của cây sau khi huấn luyện qua dữ liệu. Như vậy thông qua các tính chất của chính mô hình, các mô hình như trên có thể giải thích được những quyết định của mình. Tuy nhiên những mô hình thuộc loại này đa số có hiệu suất dự đoán thấp hơn so với các mô hình tiên tiến hiện tại như mạng nơ ron nhân tạo. Mà các mô hình mạng tiên tiến hiện nay hầu hết được coi là một hộp đen (black-box), khó có thể giải thích được. Để giải quyết các trường hợp thế này, phương pháp post-hoc explainability ra đời, các phương pháp này sẽ phát triển một mô hình riêng biệt để giải thích cho các quyết định của mô hình đưa ra dự đoán. Một số ví dụ cho các phương pháp này như Visualization Explanation của Grad-Cam và Feature Relevance của SHAP.

Hình 2: Ví dụ về các phương pháp post-hoc explanation như Visualization Explanation của Grad-Cam (bên trái) và Feature Relevance của SHAP (bên phải).

Các phương pháp post-hoc explainability này có thể giải thích được cho các mô hình black box như mạng nơ ron, tuy nhiên độ tin cậy vào sự giải thích của các mô hình này thấp hơn so với các phương pháp transparent model. Đã có nhiều nghiên cứu chỉ ra rằng việc cố gắng dùng một phương pháp khác để giải thích mô hình hộp đen, thay vì phát triển tính minh bạch (transparent) trong các mô hình này có thể tạo ra nhiều hậu quả tiêu cực cho một số lĩnh vực. Mặc dù như thế, hiện tại hướng tiệp cận post-hoc explainability vẫn được ưu tiên hơn vì các nhà khoa học ưu tiên việc giải thích cho các mô hình có hiệu suất cao ( như mạng nơ ron). Trong tương lai, có thể sẽ có nhiều nghiên cứu tập trung vào việc phát triển tính minh bạch của các mô hình mạng nơ ron nhân tạo, từ đó tạo động lực cho AI được ứng dụng ở nhiều ngành nghề và sâu rộng hơn nữa.

Liệu rằng khả năng giải thích của AI có phải là chủ đề bàn luận sôi nổi tiếp theo trong những năm tới không? Khi mà hiệu năng của các mô hình AI hiện nay đã đạt tới một mức đáng kể và ngày càng có nhiều công nghệ AI ra đời ở nhiều lĩnh vực khác nhau. AI có thể tạo ra nhiều tác động tốt lẫn xấu cho xã hội loài người, vì thế một AI có thể giải thích được có lẽ là yêu cầu quan trọng trong tương lai.

Bài viết được thực hiện bởi: